La integración de la búsqueda en tiempo real dentro de los Modelos de Lenguaje Grande (LLM) ha transformado radicalmente el ecosistema de recuperación de información. Para los SEO Managers y directores de marketing, entender cómo plataformas como ChatGPT interpretan y ejecutan búsquedas web es hoy una competencia crítica. Ya no competimos solo por palabras clave estáticas, sino por la intención descompuesta y procesada por una inteligencia artificial.

Esta guía técnica explora en profundidad el concepto de Query Fan-out, detalla la metodología para auditar estas consultas ocultas mediante ingeniería inversa y propone estrategias de Generative Engine Optimization (GEO) para maximizar la visibilidad corporativa en la era de la IA.

¿Qué es el Query Fan-out?

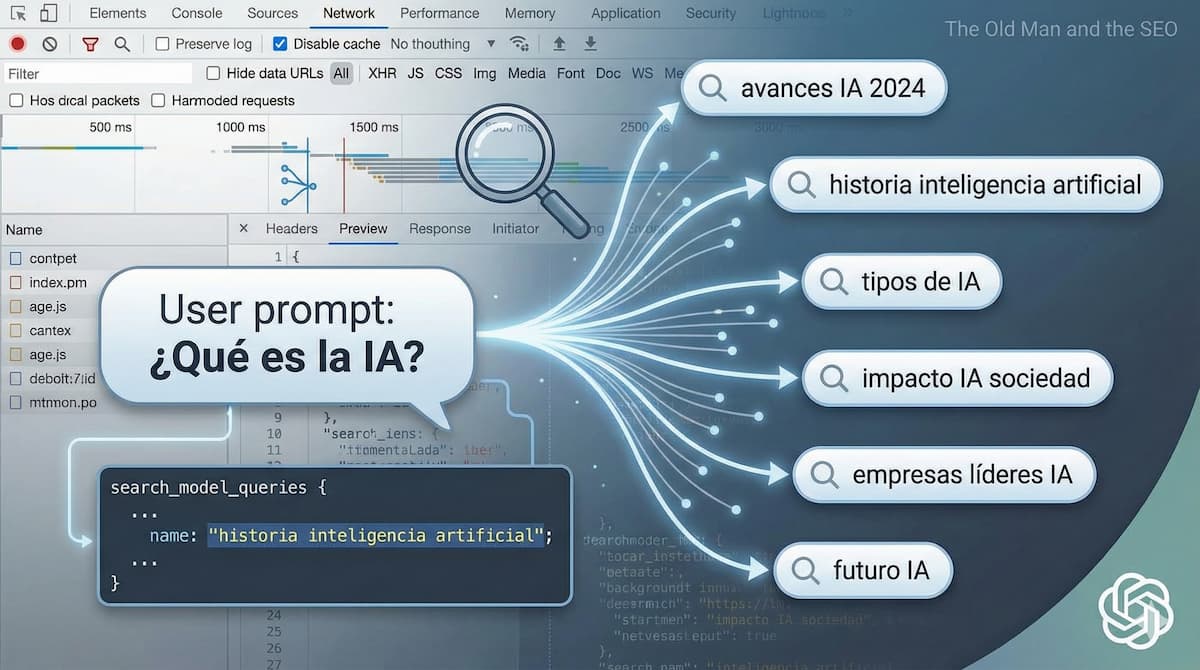

El Query Fan-out (o despliegue de consultas) es el proceso algorítmico mediante el cual un modelo de IA descompone una consulta compleja o ambigua del usuario en múltiples sub-consultas de búsqueda específicas, factuales y paralelas.

A diferencia de los buscadores tradicionales que dependen de la coincidencia de cadenas de texto, el Query Fan-out opera bajo un paradigma de razonamiento semántico. Cuando un usuario ingresa un prompt en ChatGPT, el modelo no busca esa frase literalmente. En su lugar:

- Interpreta la intención: Determina qué datos factuales necesita para construir una respuesta completa.

- Elimina el ruido: Descarta palabras vacías y retórica conversacional.

- Despliega vectores de búsqueda: Genera y ejecuta simultáneamente múltiples búsquedas orientadas a diferentes ángulos del tema (precios, especificaciones, comparativas, normativas).

Ejemplo Práctico de Fan-out

Si un usuario pregunta: “¿Conviene invertir en propiedades en Buenos Aires o Montevideo este 2026?”, el sistema no realiza esa única búsqueda. El mecanismo de fan-out generará internamente un array de consultas técnicas como:

- “mercado inmobiliario buenos aires rentabilidad 2026”

- “montevideo real estate investment roi analysis”

- “comparativa impuestos propiedad argentina vs uruguay”

Implicancia SEO: Si tu estrategia de contenidos solo ataca la long-tail keyword conversacional del usuario pero ignora las consultas técnicas y factuales que genera la máquina, tu sitio web quedará fuera del proceso de recuperación (Retrieval) y no será citado en la respuesta final.

Metodología de Auditoría: Cómo ver las consultas ocultas de ChatGPT

Para visualizar estas consultas, no es necesario depender de herramientas de terceros. Los datos residen en la comunicación entre el cliente (navegador) y el servidor de OpenAI. A continuación, se detalla el protocolo técnico para interceptar el objeto JSON search_model_queries utilizando las herramientas de desarrollo (DevTools).

Paso 1: Configuración del Entorno de Inspección

Es fundamental realizar este proceso en un entorno de escritorio (Chrome o Edge), ya que las aplicaciones móviles utilizan certificate pinning que dificulta la inspección.

- Accedé a ChatGPT.

- Hacé clic derecho en cualquier lugar de la pantalla e ingresá a Inspeccionar (o presioná F12).

- Navegá a la pestaña Network (Red).

- Filtro Clave: En la barra de búsqueda del panel de red, escribí conversation. Esto aislará las solicitudes de texto y eliminará el ruido de imágenes y scripts de telemetría.

Paso 2: Ejecución del Trigger

Ingresá un prompt que fuerce al modelo a buscar en la web (Browse with Bing). Evitá preguntas lógicas; optá por datos frescos o comparativas de mercado.

- Prompt sugerido: “Analizá la evolución del dólar MEP vs CCL en el último trimestre y proyectá tendencias para el cierre de año.”

Paso 3: Análisis Forense del JSON

Una vez que ChatGPT comience a generar la respuesta (verás el indicador “Searching the web”), seguí estos pasos en el panel de Network:

- Seleccioná la solicitud que aparece filtrada (generalmente inicia con el ID de la conversación).

- Dirigite a la sub-pestaña Response o Preview.

- Utilizá el buscador interno del panel (Ctrl + F) para localizar la clave: search_model_queries.

Estructura de Datos Actualizada (2025-2026): OpenAI ha optimizado la salida de datos. Lo que antes era un objeto anidado complejo ahora se presenta habitualmente como un array plano de strings. Encontrarás algo similar a:

JSON

"search_model_queries": [

"cotizacion dolar mep ccl historico 2025 2026",

"argentina financial market exchange rate forecast",

"analisis brecha cambiaria argentina ultimo trimestre"

]Estas cadenas de texto son las keywords reales por las que tu contenido debe competir. Es vital notar que, frecuentemente, el modelo traduce la intención al inglés para consultar fuentes globales de mayor autoridad, incluso si el input original fue en español.

Estrategia GEO (Generative Engine Optimization)

La optimización para motores generativos requiere un cambio de mentalidad: dejar de optimizar para el clic y empezar a optimizar para la citación. Este nuevo paradigma de SEO para LLMs exige que nuestros contenidos estén diseñados para ser ingeridos por máquinas, no solo leídos por humanos.

Basándonos en la auditoría de fan-out, estas son las acciones tácticas recomendadas:

1. Atomización y Estructura Modular

El análisis del fan-out demuestra que la IA busca fragmentos de información específicos. Si el modelo despliega consultas separadas para “precios”, “riesgos” y “beneficios”, tu contenido debe reflejar esa estructura modular.

- Acción: Utilizá encabezados semánticos (H2, H3) que respondan directamente a los vectores de búsqueda detectados. Evitá párrafos densos; facilitá la extracción de entidades.

2. Densidad de Hechos (Fact-Density)

Los LLM priorizan la veracidad y la autoridad. Para ser elegido como fuente de “grounding” (fundamentación), tu contenido debe ser rico en datos duros.

- Acción: Incorporá tablas comparativas, cifras exactas, fechas y citas a fuentes primarias. Un artículo con una tabla HTML clara sobre “Tasas de Interés 2026” tiene muchas más posibilidades de ser ingerido y citado que un texto de opinión.

3. Gestión de la Brecha Lingüística

Dado que el fan-out suele recurrir al inglés para búsquedas técnicas o B2B, los sitios exclusivamente en español pueden perder visibilidad.

- Acción: No es necesario traducir todo el sitio, pero sí enriquecerlo semánticamente. Incluí términos técnicos en inglés entre paréntesis o en atributos meta. Esto ayuda al modelo a conectar tu contenido local con su búsqueda interna global.

Conclusión

El dominio del Query Fan-out representa una ventaja competitiva asimétrica para el SEO Manager moderno. Mientras la competencia sigue obsesionada con volúmenes de búsqueda tradicionales, la capacidad de auditar técnicamente qué está preguntando realmente la IA nos permite alinear nuestra arquitectura de información con la lógica de los nuevos motores de respuesta.

La recomendación es clara: integrá esta auditoría en tus procesos mensuales, analizá las brechas entre lo que el usuario pide y lo que la IA busca, y optimizá tu contenido para ser la fuente de verdad ineludible en tu industria.

Luciano Truck es SEO Manager en MD Marketing Digital desde 2018. Dirige un equipo enfocado en SEO y estrategias digitales. Estudia Ciencias Físicas en la UBA y posee certificaciones en Google Analytics y herramientas SEO. Apasionado por la música, los deportes y la educación.

Deja un comentario